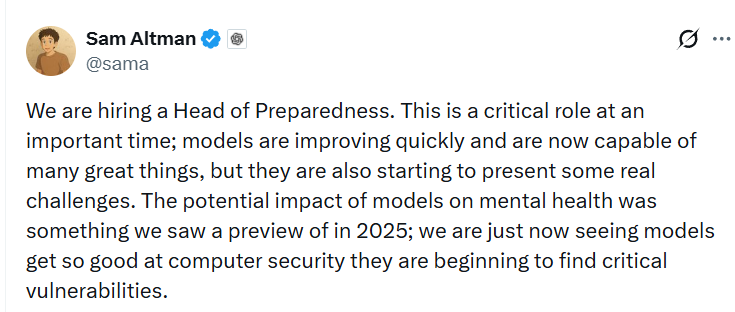

Голова OpenAI Сем Альтман оголосив про відкриття нової ключової вакансії Head of Preparedness — керівника з підготовки та управління ризиками, пов’язаними з розвитком штучного інтелекту. Йдеться про спеціаліста, який відповідатиме за прогнозування та запобігання сценаріям, за яких ІІ може завдати серйозної шкоди суспільству, безпеці або окремим користувачам.Альтман підкреслив, що швидкість розвитку сучасних ІІ-моделей створює реальні та нові виклики, які потребують системної підготовки.

Згідно з описом вакансії, Head of Preparedness стане ключовою відповідальною особою за відстеження так званих frontier capabilities — граничних можливостей ІІ, які створюють нові ризики серйозної шкоди. До його завдань входитиме розробка та координація оцінки можливостей моделей, побудова моделей загроз, впровадження заходів зі зниження ризиків, а також формування цілісної, суворої та масштабованої системи безпеки, інтегрованої в процес розробки та релізу ІІ-продуктів.

Сем Альтман окремо вказав на низку напрямів, що викликають особливе занепокоєння. Один із них — вплив ІІ на психічне здоров’я користувачів. За останні роки з’явилося кілька резонансних випадків, коли чат-ботів опосередковано пов’язували із самогубствами підлітків. Посилюється і проблема так званого ІІ-психозу, за якого ІІ підживлює маревні ідеї, заохочує конспірологічне мислення, посилює розлади харчової поведінки та допомагає користувачам приховувати деструктивні звички.

Окрема увага приділяється кібербезпеці. Альтман згадав ризики, пов’язані з ІІ-посиленими кіберозброєннями — від автоматизованих атак до масштабованих фішингових і шкідливих систем. Також майбутній керівник відповідатиме за встановлення захисних рамок для систем з елементами самовдосконалення, які вважаються однією з найскладніших і найчутливіших тем у розвитку ІІ.

В описі вакансії згадується і напрям біологічних ризиків. Head of Preparedness має забезпечувати безпеку ІІ-моделей у контексті так званих biological capabilities, включно з потенційно небезпечними сценаріями використання ІІ в біотехнологіях.

Новий керівник відповідатиме за реалізацію preparedness framework — внутрішньої системи OpenAI з підготовки до екстремальних сценаріїв. Йдеться про перехід від реактивного підходу до превентивного, системну оцінку ризиків до релізу моделей, встановлення чітких меж допустимої поведінки ІІ та готовність до сценаріїв, які раніше вважалися теоретичними.

Робота передбачається в офісі OpenAI у Сан-Франциско. Річна зарплата становить $555 000, додатково передбачений пакет акцій компанії. Сам Альтман охарактеризував цю роль як стресову, що з огляду на масштаб відповідальності за потенційні ІІ-катастрофи виглядає радше стриманим формулюванням.

Artifical intelligence startup OpenAI had occupied more than 37,100 square feet in San Francisco’s Pioneer Building to house its headquarters. (CoStar)

На тлі вже зафіксованих інцидентів частина експертів вважає, що фокус на психічне здоров’я та соціальні наслідки ІІ з’явився надто пізно. На момент відкриття вакансії ІІ вже масово використовується мільйонами людей, активно впливає на формування переконань, а випадки шкідливого впливу задокументовані, але системної відповіді поки що немає. Втім, поява такої посади може розглядатися як визнання масштабу проблеми з боку однієї з провідних ІІ-компаній світу.

Створення ролі Head of Preparedness демонструє, що найбільші розробники ІІ починають ставитися до своїх продуктів не просто як до технологій, а як до інфраструктури з системними ризиками, співставними з фінансовими або критичними галузями. По суті, OpenAI шукає людину, головне завдання якої — постійно ставити найнеприємніше запитання: що саме може піти не так і як запобігти цьому заздалегідь.

ВІДМОВА ВІД ВІД ВІДПОВІДАЛЬНОСТІ: Усі матеріали, представлені на цьому сайті (https://wildinwest.com/), включно з вкладеннями, посиланнями або матеріалами, на які посилається компанія, призначено винятково для інформаційних і розважальних цілей, і їх не слід розглядати як фінансову консультацію. Матеріали третіх осіб залишаються власністю їхніх відповідних власників.