?? Сверхразумный искусственный интеллект (ИИ), способный действовать самостоятельно и принимать решения, может стать угрозой для всего человечества. Так считает сооснователь Ethereum Виталик Бутерин, один из ведущих мыслителей в области блокчейн-технологий и децентрализованных систем (про него мы писали неоднократно).

Проблема согласования ценностей

Бутерин обратил внимание на фундаментальную проблему в развитии ИИ: человечество пока не умеет согласовывать общие мировые ценности на уровне, достаточном для гарантии безопасности сверхразумного ИИ.

В комментарии к посту в сети Х 3D-художника с ником Utah teapot он отметил:

«Мы знаем множество вещей, которые явно противоречат человеческим ценностям (например, убийство или заключение невинных людей), и аргумент заключается в том, что мы недостаточно хорошо умеем согласовывать цели, чтобы гарантировать, что единственный суперразумный ИИ будет избегать даже этого».

Дальше он продолжил: «Как вообще может существовать понятие AI alignment? Я всегда спрашиваю: “согласование с чем?”. Никто никогда не отвечает ничего, кроме как “с человеческими ценностями”. Но целостных, непротиворечивых человеческих ценностей не существует. Я до сих пор не понимаю. Что мы вообще исследуем? Абсурдно, что это превращается в растущую индустрию. Фиктивная работа».

Иными словами, попытки «согласовать» ИИ с человеческими ценностями сталкиваются с тем, что эти ценности противоречивы и фрагментарны. То, что одно общество считает этичным, другое может воспринимать как недопустимое.

Бутерин приводит в пример очевидные этические противоречия в нашем мире: убийство, заключение невиновных, злоупотребление властью. Он отмечает: «Мы пока недостаточно хороши в согласовании, чтобы гарантировать, что единичный сверхразумный ИИ избежит даже этого».

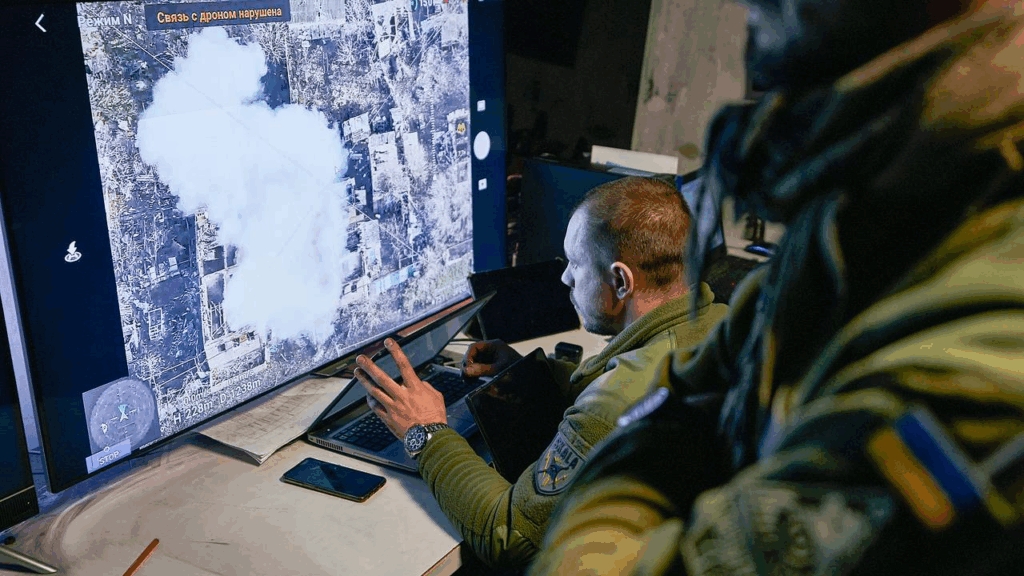

Централизация и военное использование ИИ

Utah teapot подчеркнул, что современные тенденции в разработке ИИ идут в сторону ограничения публичного доступа. Крупные компании выпускают версии своих ИИ-систем, которые могут использоваться в военных целях или для контроля информации.

«Я глубоко обеспокоен тем, что централизация доступа к ИИ-технологиям позволяет навязывать как вопросы безопасности то, что на самом деле ею не является — например, обсуждения вокруг “психоза” от LLM. Тем самым возникает риск нанести вред уникальным или маргинальным культурам и их ценностям».

Бутерин поддерживает эти опасения: «Я думаю, что наибольшие риски будут исходить от военных и других структур, обладающих большой властью, позволяющей им выводить себя из-под действия правил безопасности, которые для всех остальных идут по умолчанию».

В качестве примера Utah teapot упомянул стартап Anthropic, разрабатывающий альтернативные “гражданские” модели ИИ и продающий их правительствам. Такие технологии могут применяться в военной и разведывательной деятельности, что повышает риск неконтролируемых последствий.

Катастрофический сценарий и единичный агент

Бутерин предупреждает: опасность возрастает, если на планете появится один сверхразумный ИИ-агент, обладающий собственной волей и способностью действовать как субъект. В такой ситуации система сможет обходить любые правила и ограничения, что делает катастрофический исход реальной угрозой.

«Если среда будет плюралистической, ни одна из систем не сможет тотально контролировать ситуацию. Однако для ее создания одних лишь рыночных механизмов недостаточно. Необходимы намеренные усилия, включая изменения в законах и стимулах, которые не понравятся большим корпорациям».

Другими словами, безопасное будущее ИИ невозможно построить без глобального регулирования, прозрачных правил и ограничений, а также участия международного сообщества.

? Международные инициативы

Напомним, что ещё в 2022 году министр информационных технологий Индии Раджив Чандрасекар призвал к созданию глобальных стандартов безопасности ИИ, гарантирующих, что технологии будут безопасны для человека.

Сегодня вопрос безопасного развития ИИ выходит на первый план не только в технологических кругах, но и в политике, науке и общественных дискуссиях. Угроза сверхразумного ИИ — это не фантастика, а реальная стратегическая задача для всего человечества.

ОТКАЗ ОТ ОТВЕТСТВЕННОСТИ: Все материалы, представленные на этом сайте (https://wildinwest.com/), включая вложения, ссылки или материалы, на которые ссылается компания, предназначены исключительно для информационных и развлекательных целей и не должны рассматриваться как финансовая консультация. Материалы третьих лиц остаются собственностью их соответствующих владельцев.